תמונות AI מזויפות של מדורו במעצר מציפות את הרשת – כך תזהו אותן

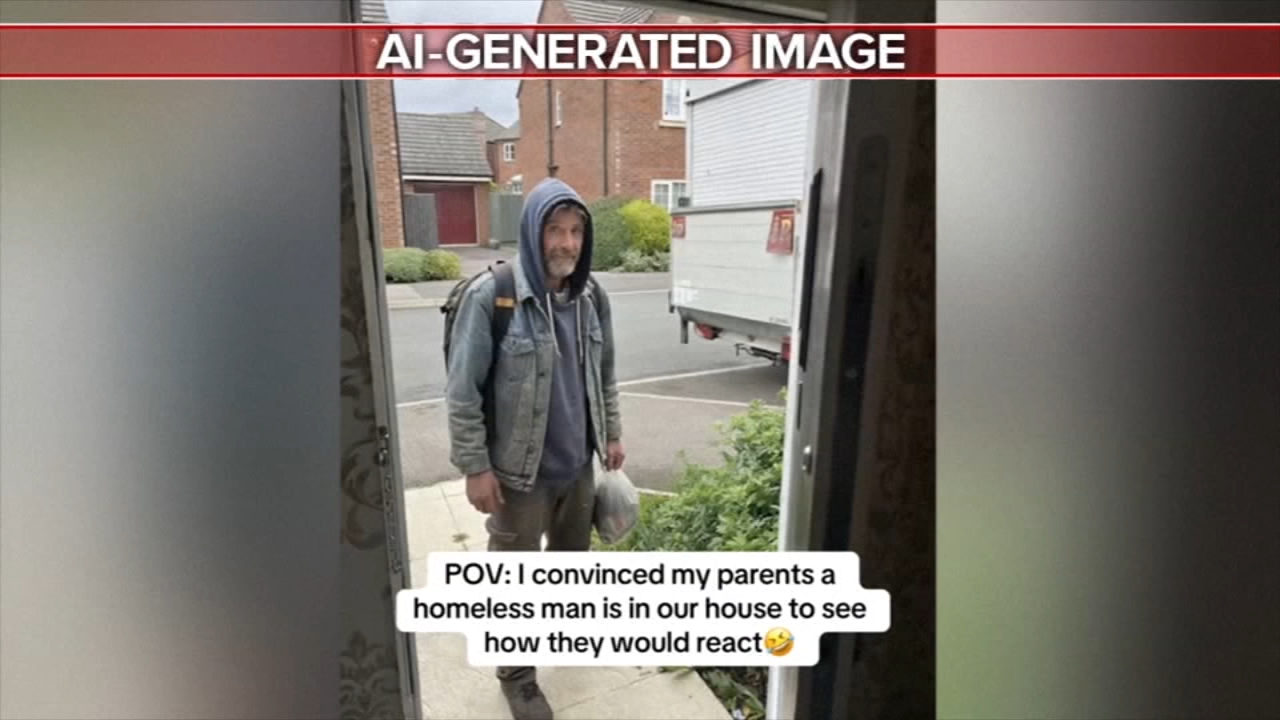

תמונות AI מזויפות שנוצרו שעות ספורות לאחר מעצרו של ניקולס מדורו הציפו את הרשתות החברתיות וצברו עשרות מיליוני צפיות. צוותי בדיקה זיהו את הזיוף באמצעות כלים כמו SynthID של גוגל, מה שמדגיש את האתגרים במאבק בהתפשטות מידע כוזב בעידן הבינה המלאכותית.